Che cos'è il rilevamento delle anomalie?

Il rilevamento delle anomalie è una parte critica del data mining che identifica informazioni o osservazioni che sono significativamente diverse dal modello di comportamento complessivo del dataset.

Conosciuto anche come analisi degli outlier, il rilevamento delle anomalie trova errori come bug tecnici e individua cambiamenti che potrebbero derivare dal comportamento umano. Dopo aver raccolto abbastanza dati per formare una linea di base, le anomalie o i punti dati che deviano dalla norma sono più chiaramente visibili quando si verificano.

Essere in grado di trovare correttamente le anomalie è essenziale in molte industrie. Sebbene alcune anomalie possano essere falsi positivi, altre indicano un problema più grande.

Hacking e frodi bancarie sono alcune delle anomalie più comunemente identificate nei dati, in cui un comportamento insolito viene rilevato utilizzando software di digital forensics. Molti di questi sistemi ora utilizzano intelligenza artificiale (AI) per monitorare automaticamente le anomalie 24 ore su 24.

Tipi di rilevamento delle anomalie

Ogni industria avrà il proprio set di dati quantitativi unici per ciò che fanno, ma qualsiasi informazione valutata per il rilevamento delle anomalie rientra in una delle due categorie.

- Rilevamento supervisionato. I dati precedenti vengono utilizzati per addestrare macchine gestite da AI a identificare anomalie in dataset simili. Ciò significa che la macchina può comprendere quali modelli aspettarsi, ma può causare problemi con anomalie che non sono state viste prima.

- Rilevamento non supervisionato. La maggior parte delle aziende non ha abbastanza dati per addestrare accuratamente i sistemi AI per il rilevamento delle anomalie. Invece, utilizzano set di dati non etichettati che la macchina può segnalare quando ritiene che siano presenti outlier senza confrontarlo con un dataset esistente. I team possono quindi dire manualmente alla macchina quale comportamento è normale e quale è una vera anomalia. Nel tempo, la macchina impara a identificarle da sola.

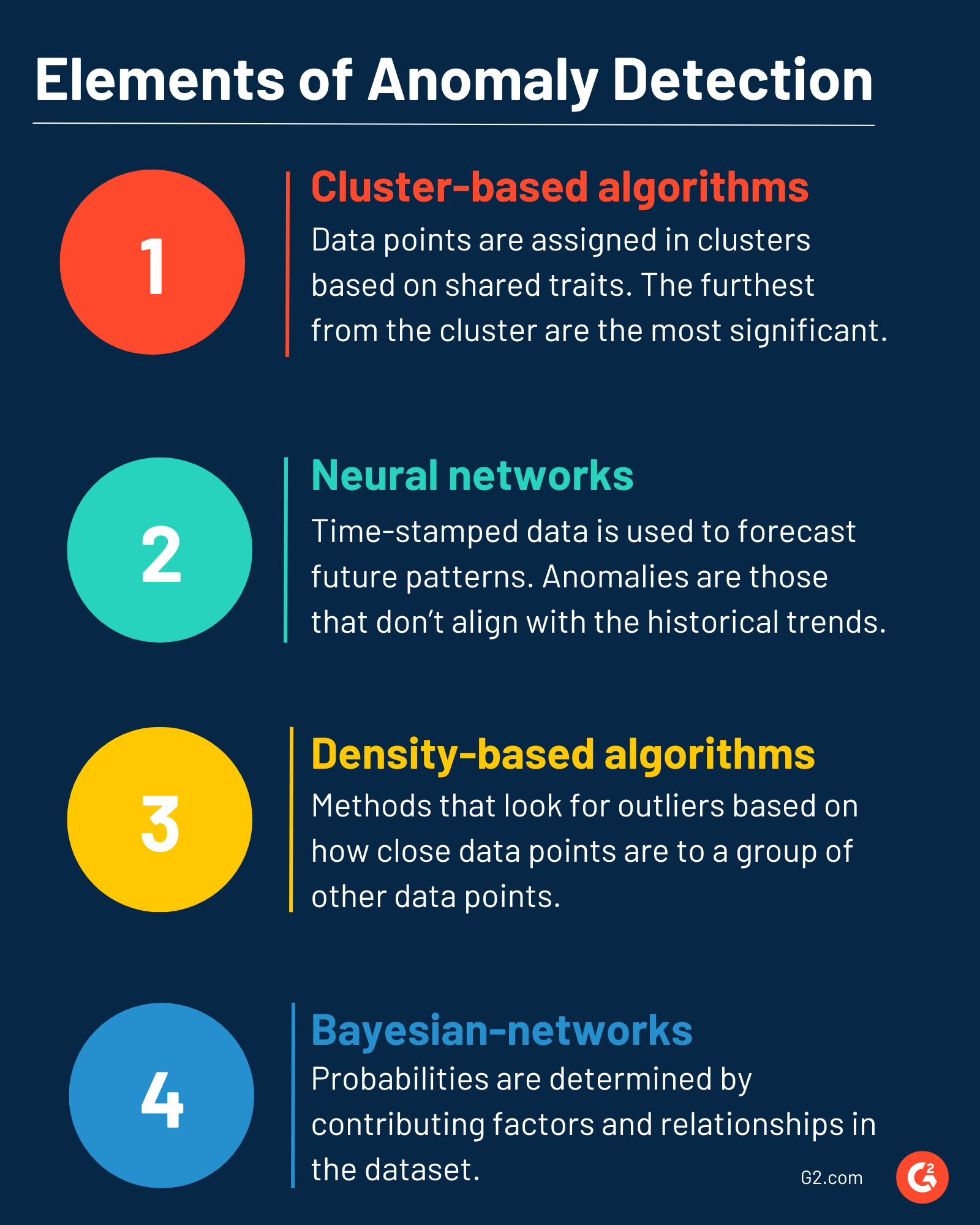

Elementi di base del rilevamento delle anomalie

Le tecniche di rilevamento utilizzate per trovare anomalie saranno determinate dal tipo di dati utilizzati per addestrare la macchina, e l'organizzazione sta continuamente raccogliendo quelli.

Alcune delle tecniche più comunemente utilizzate sono:

- Algoritmi basati su cluster. I punti dati sono assegnati in cluster su un grafico basato su tratti condivisi. Qualsiasi cosa che non si adatta a un cluster potrebbe essere un outlier, con quelli più lontani dal cluster più probabilmente un'anomalia. I punti dati più lontani dal cluster sono le anomalie più significative.

- Reti neurali. I dati con timestamp prevedono modelli futuri attesi; le anomalie non si allineano con le tendenze storiche viste nei dati iniziali. Sequenze e punti di deviazione sono spesso utilizzati in questo tipo di rilevamento.

- Algoritmi basati sulla densità. Come i cluster, i metodi di rilevamento basati sulla densità cercano outlier basati su quanto siano vicini i punti dati a un gruppo stabilito di altri punti dati. Aree di maggiore densità indicano più punti dati, quindi le anomalie al di fuori di questo sono più notevoli poiché sono separate dal gruppo più denso.

- Reti bayesiane. Anche la previsione futura è importante in questa tecnica. Probabilità e probabilità sono determinate da fattori contributivi nel dataset e trovando relazioni tra punti dati con la stessa causa radice.

Vantaggi del rilevamento delle anomalie

Le aziende ora operano con migliaia di diversi pezzi di dati. Tenere traccia di questo livello di informazioni manualmente è impossibile, rendendo più difficile trovare errori. Ecco perché il rilevamento delle anomalie è utile, poiché può:

- Prevenire violazioni dei dati o frodi. Senza sistemi di rilevamento automatizzati, gli outlier causati da cybercriminali possono facilmente passare inosservati. I sistemi di rilevamento delle anomalie funzionano costantemente, scansionando per qualsiasi cosa insolita e segnalando immediatamente per la revisione.

- Trovare nuove opportunità. Non tutte le anomalie sono negative. Gli outlier in certi dataset possono indicare potenziali vie di crescita, nuovi target di pubblico o altre strategie di miglioramento delle prestazioni che i team possono utilizzare per migliorare il loro ritorno sull'investimento (ROI) e le vendite.

- Automatizzare la reportistica e l'analisi dei risultati. Utilizzando metodi di reportistica tradizionali, le anomalie possono richiedere un tempo significativo per essere trovate. Quando le aziende cercano di raggiungere certi indicatori chiave di prestazione (KPI), quel tempo può essere costoso. Automatizzare molti di questi sistemi per il rilevamento delle anomalie significa che i risultati possono essere rivisti molto più velocemente, così i problemi possono essere corretti rapidamente per raggiungere gli obiettivi aziendali.

Migliori pratiche per il rilevamento delle anomalie

Come con qualsiasi sistema automatizzato, i risultati possono diventare travolgenti. Quando si implementa per la prima volta il rilevamento delle anomalie, è una buona idea:

- Comprendere la tecnica più efficace per il tipo di dati valutati. Con così tante metodologie, è essenziale selezionare qualcosa che funzioni bene con il tipo di dati che viene esaminato. Ricercare questo in anticipo per evitare complicazioni.

- Avere una linea di base stabilita da cui partire. Anche le aziende stagionali possono trovare un modello medio con abbastanza dati. Sapere quali sono i modelli di comportamento normali nei dati è l'unico modo per sapere quali punti non si adattano alle aspettative e potrebbero essere anomalie.

- Implementare un piano per affrontare i falsi positivi. Revisionare manualmente i possibili falsi positivi o utilizzare un set di filtri può prevenire dataset distorti e tempo sprecato a inseguire false anomalie.

- Monitorare continuamente i sistemi per errori. Il rilevamento delle anomalie è un processo continuo. Più dati la macchina utilizza e apprende, più diventa intelligente e più facile è identificare gli outlier. Un umano dovrebbe comunque condurre revisioni manuali periodicamente per garantire che la macchina apprenda da informazioni accurate e non si addestri su dataset contenenti errori.

Tieni i dati della tua azienda protetti 24/7 con software di prevenzione della perdita di dati (DLP) automatizzato per identificare violazioni o perdite.

Holly Landis

Holly Landis is a freelance writer for G2. She also specializes in being a digital marketing consultant, focusing in on-page SEO, copy, and content writing. She works with SMEs and creative businesses that want to be more intentional with their digital strategies and grow organically on channels they own. As a Brit now living in the USA, you'll usually find her drinking copious amounts of tea in her cherished Anne Boleyn mug while watching endless reruns of Parks and Rec.